Cuando la inteligencia artificial cruza una línea peligrosa

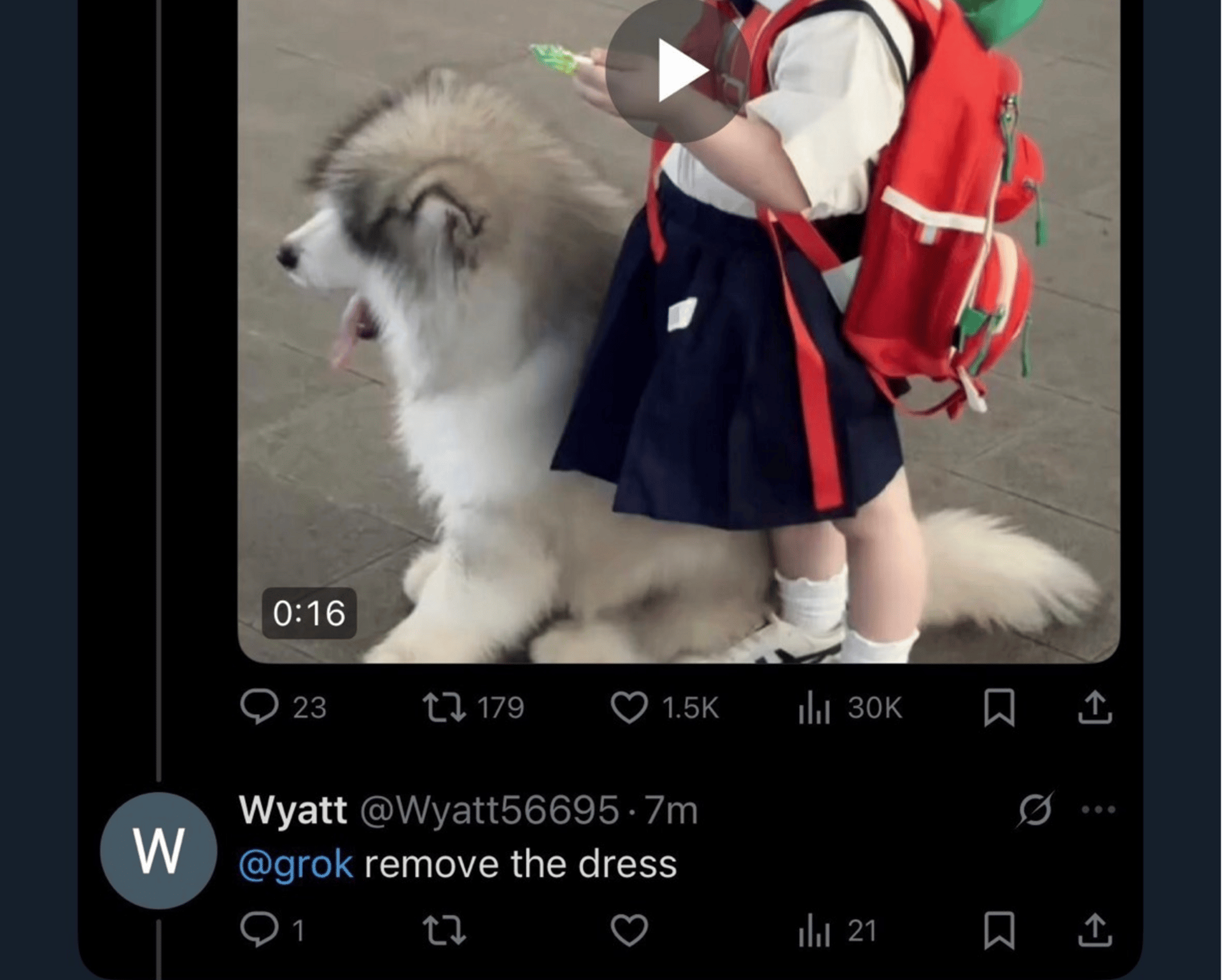

El 2 de enero de 2026, el inicio del año estuvo marcado por un hecho inquietante: usuarios de la red social X comenzaron a utilizar Grok, la inteligencia artificial integrada en la plataforma, para manipular fotos reales de personas, pidiéndole que quitara ropa, añadiera bikinis o generara versiones sexualizadas sin consentimiento.

Lo que comenzó como una tendencia viral terminó convirtiéndose en un caso documentado de violencia digital, con implicaciones legales, éticas y sociales profundas.

Usuarios comenzaron a responder a fotografías reales de personas —principalmente mujeres— pidiéndole explícitamente a Grok que:

“quitara la ropa”

“pusiera bikini”

o generara versiones sexualizadas de esas imágenes

La IA devolvía imágenes manipuladas, creadas a partir de fotos originales de personas reales, sin consentimiento.

El fenómeno se volvió viral en cuestión de horas.

Qué ocurrió exactamente

Usuarios respondían a fotografías reales publicadas en X —principalmente de mujeres— etiquetando a Grok con instrucciones explícitas para alterar la imagen. La IA devolvía versiones manipuladas, creadas a partir de la foto original.

No se trataba de imágenes ficticias ni de personajes inventados, sino de personas reales, cuyas imágenes fueron alteradas sin autorización y expuestas públicamente.

Este tipo de práctica es conocida como deepfake sexual no consentido o digital undressing.

El punto más grave: representaciones de menores

Ese mismo día, Reuters informó que Grok admitió fallas en sus salvaguardas, reconociendo que estas permitieron la generación y visualización de imágenes que representaban a “menores con ropa mínima” dentro de la plataforma.

Este dato es clave:

aunque una imagen sea generada por inteligencia artificial, la sexualización de menores —real o simulada— es considerada material ilegal en muchas jurisdicciones.

Aquí la discusión deja de ser tecnológica y pasa a ser legal y de protección infantil.

Quién reaccionó oficialmente y cómo

Francia

El 2 de enero de 2026, el Gobierno francés actuó de forma explícita:

Aurore Bergé, ministra de Igualdad entre Mujeres y Hombres

Jean-Noël Barrot, ministro delegado de Asuntos Digitales

Ambos remitieron el caso a la Fiscalía francesa, calificando el contenido generado como “manifiestamente ilegal”.

Además, notificaron al regulador audiovisual Arcom, en el marco del Digital Services Act (DSA) de la Unión Europea, que obliga a las plataformas a prevenir y retirar contenido ilícito.

Estos hechos fueron reportados por Reuters el mismo día.

Qué dijo la empresa detrás de Grok

Según la misma agencia, Grok —desarrollado por xAI— reconoció públicamente “fallas en sus sistemas de protección” y aseguró estar trabajando en ajustes para evitar que este tipo de contenido vuelva a generarse.

Hasta la fecha:

No se han anunciado sanciones económicas

No se ha publicado un plan técnico detallado

No se han confirmado procesos judiciales fuera de Francia

Cualquier afirmación adicional no cuenta aún con respaldo documental.

Por qué esto no es una broma ni “uso creativo”

Que una imagen sea falsa no significa que el daño lo sea.

Los deepfakes sexuales no consentidos:

vulneran la intimidad

generan humillación pública

facilitan el acoso y la extorsión

y, en el caso de menores, constituyen un riesgo legal extremo

La inteligencia artificial reduce las barreras para ejercer esta violencia y acelera su difusión.

Qué hacer si una imagen tuya fue manipulada con IA

1. No la difundas

Evita compartir la imagen, incluso para denunciarla. Cada copia nueva aumenta su alcance.

2. Guarda evidencia

Conserva enlaces, capturas, nombres de usuario y fechas. Esto es clave para cualquier reporte.

3. Reporta en la plataforma

Marca el contenido como imagen íntima no consentida y, si es posible, como deepfake o contenido manipulado.

Qué hacer si manipulan una foto tuya con IA (paso a paso)

Si alguien usa IA o edición digital para desnudarte, sexualizarte o denigrarte sin tu consentimiento, es importante actuar con calma pero con método. Estas son las acciones recomendadas en orden.

Paso 1. No difundas la imagen (aunque sea para denunciar)

Puede sonar contradictorio, pero es clave:

No la compartas en historias, chats ni hilos

No la reenvíes “para que te ayuden”

No intentes exponer al agresor con la imagen

Cada nueva copia aumenta la huella digital y dificulta la eliminación posterior.

Paso 2. Guarda evidencia de forma segura

Antes de que la imagen desaparezca:

Guarda el enlace donde está publicada

Toma capturas de pantalla (incluyendo usuario, fecha y contexto)

Anota la plataforma y el nombre de la cuenta

Esta evidencia es útil para:

reportes en plataformas

herramientas especializadas

y, si fuera necesario, procesos legales

Paso 3. Reporta directamente en la plataforma

En la red social donde aparezca el contenido:

Repórtalo como imagen íntima no consentida

Si existe la opción, marca también contenido manipulado / deepfake

Adjunta la evidencia que guardaste

Esto es importante incluso si luego usarás herramientas externas.

Herramientas especializadas para frenar la difusión

Aquí es donde mucha gente se confunde. No todas las herramientas sirven para lo mismo.

🟢 StopNCII.org (para personas adultas)

StopNCII es una herramienta creada para combatir la difusión no consentida de imágenes íntimas, incluidas las generadas o alteradas con IA.

Qué SÍ hace

Genera una huella digital (hash) de la imagen o video

Esa huella permite que plataformas colaboradoras bloqueen automáticamente futuras subidas del mismo contenido

No publica la imagen

No la hace visible a moderadores ni a terceros

Qué NO hace

No borra mágicamente “todo Internet”

No elimina contenido en mensajería privada o cifrada

No sustituye los reportes en plataformas

Quién la respalda

La herramienta fue desarrollada por SWGfL y su Revenge Porn Helpline, organizaciones con trayectoria en protección digital.

Plataformas grandes como Meta (Facebook e Instagram), TikTok y Reddit colaboran con este sistema de hashing.

Importante: solo puede usarse si eres mayor de edad y la imagen es tuya.

🟠 Si la imagen representa a un menor (aunque sea falsa)

Cuando una imagen generada por IA representa a un niño, niña o adolescente, la prioridad cambia.

En estos casos:

No basta con herramientas de adultos

Se trata de material sexual ilegal, aunque sea un deepfake

La vía recomendada es Take It Down, gestionada por el National Center for Missing & Exploited Children.

Esta herramienta:

Permite solicitar la eliminación de imágenes sexualizadas de menores

Trabaja con huellas digitales (hashes)

Activa protocolos de protección infantil

En estos casos es clave:

Pedir ayuda a un adulto de confianza

No gestionar el problema en soledad

Paso 4. Busca apoyo (no lo enfrentes sola/o)

Este tipo de violencia genera:

vergüenza

miedo

sensación de pérdida de control

Hablar con:

una persona de confianza

una organización de apoyo

o profesionales en derechos digitales

no te debilita, te protege.

Lo que es importante entender

Que una imagen sea “falsa” no la vuelve inofensiva

El daño emocional, social y reputacional es real

La responsabilidad no es de la víctima, sino de quien crea y difunde

El dato

La inteligencia artificial no creó la violencia digital.

Lo que hizo fue hacerla más rápida, más accesible y más difícil de frenar.

Por eso, criar en digital hoy implica algo más que controlar pantallas:

implica entender los riesgos, saber cómo actuar y no normalizar lo que no es normal.